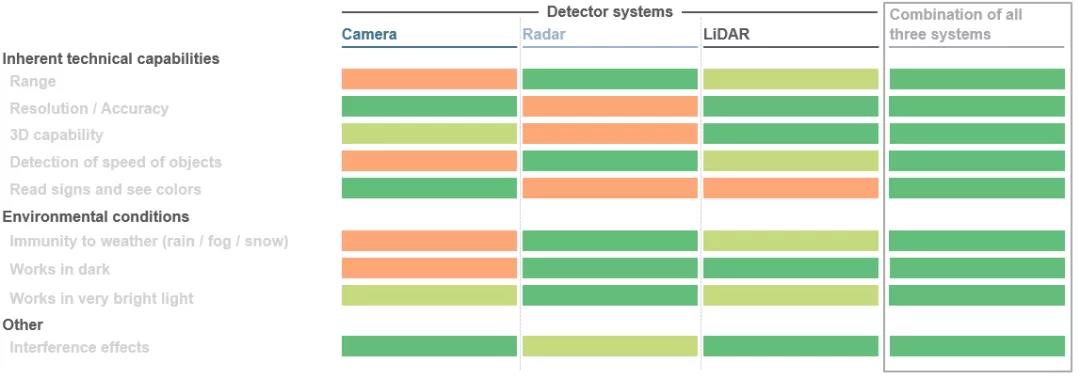

Et stort sprang finner sted innen mobilitet. Dette gjelder enten det er i bilsektoren, hvor løsninger for autonom kjøring utvikles, eller i industrielle applikasjoner som bruker robotikk og automatiserte veiledede kjøretøyer. De ulike komponentene i hele systemet skal samarbeide med hverandre og utfylle hverandre. Hovedmålet er å lage en sømløs 3D-visning rundt kjøretøyet, bruke dette bildet til å beregne objektavstander og sette i gang neste bevegelse av kjøretøyet ved hjelp av spesielle algoritmer. Faktisk brukes tre sensorteknologier samtidig her: LiDAR (LiDAR), radar og kameraer. Avhengig av det spesifikke bruksscenarioet, har disse tre sensorene sine egne fordeler. Å kombinere disse fordelene med redundante data kan forbedre sikkerheten betraktelig. Jo bedre disse aspektene er koordinert, jo bedre vil den selvkjørende bilen kunne navigere i omgivelsene.

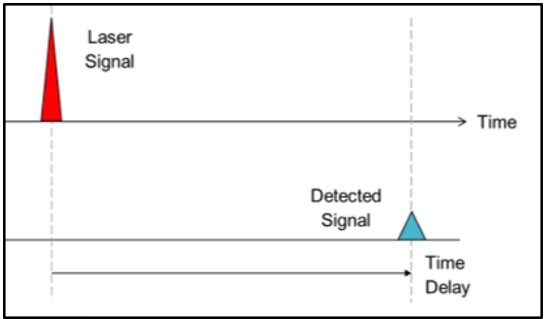

1. Direkte flytid (dToF):

I time-of-flight-tilnærmingen bruker systemprodusenter lysets hastighet til å generere dybdeinformasjon. Kort fortalt skytes rettede lyspulser ut i omgivelsene, og når lyspulsen treffer et objekt, reflekteres den og registreres av en detektor nær lyskilden. Ved å måle tiden det tar for strålen å nå objektet og returnere, kan objektavstanden bestemmes, mens i dToF-metoden kan avstanden til en enkelt piksel bestemmes. De mottatte signalene blir til slutt behandlet for å utløse tilsvarende handlinger, for eksempel kjøretøyunndragelser for å unngå kollisjoner med fotgjengere eller hindringer. Denne metoden kalles direkte time-of-flight (dToF) fordi den er relatert til den nøyaktige "time-of-flight" av strålen. LiDAR-systemer for autonome kjøretøy er et typisk eksempel på dToF-applikasjoner.

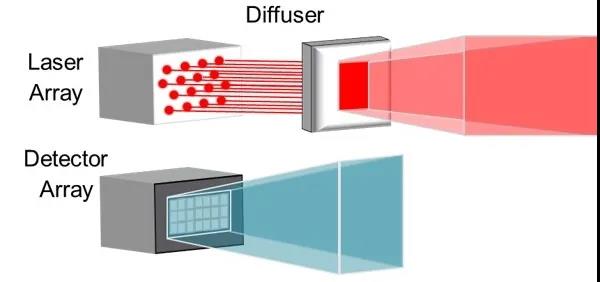

2. Indirekte flytid (iToF):

Den indirekte time-of-flight-tilnærmingen (iToF) er lik, men med en merkbar forskjell. Belysning fra en lyskilde (vanligvis en infrarød VCSEL) forsterkes av et unnvikende ark og pulser (50 % driftssyklus) sendes ut i et definert synsfelt.

I nedstrømssystemet vil et lagret "standardsignal" utløse detektoren i en periode dersom lyset ikke møter en hindring. Hvis et objekt avbryter dette standardsignalet, kan systemet bestemme dybdeinformasjonen til hver definert piksel i detektoren basert på den resulterende faseforskyvningen og tidsforsinkelsen til pulstoget.

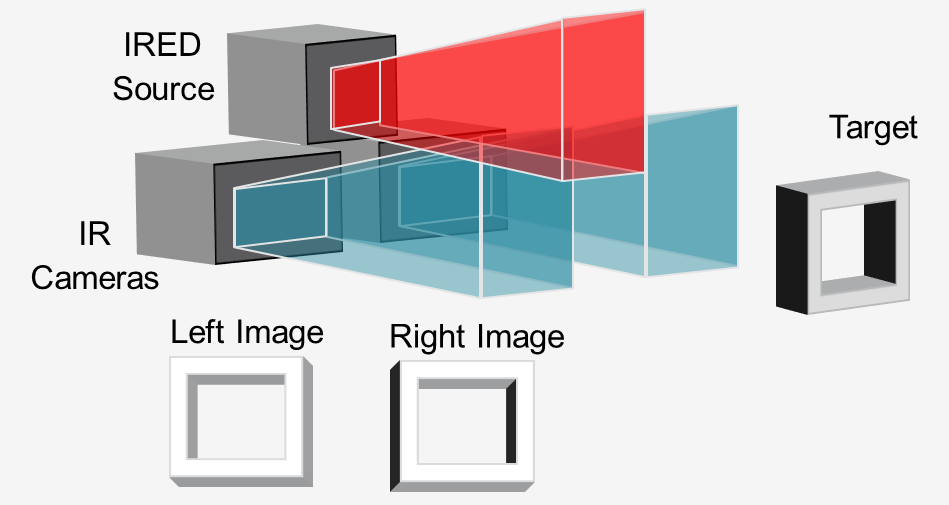

3. Active Stereo Vision (ASV)

I «active stereo vision»-metoden lyser en infrarød lyskilde (vanligvis en VCSEL eller IRED) opp scenen med et mønster, og to infrarøde kameraer tar opp bildet i stereo.

Ved å sammenligne de to bildene kan nedstrøms programvare beregne nødvendig dybdeinformasjon. Lys støtter dybdeberegninger ved å projisere et mønster, selv på objekter med lite tekstur som vegger, gulv og bord. Denne tilnærmingen er ideell for nærliggende, høyoppløselig 3D-sensing på roboter og automatiserte veiledede kjøretøy (AGV) for å unngå hindringer.

Copyright @ 2020 Shenzhen Box Optronics Technology Co., Ltd. - China Fiber Optic Modules, Fiber Coupled Lasers Produsenter, Laserkomponenter leverandører alle rettigheter reservert.